type

status

date

slug

summary

tags

category

icon

password

URL

Rating

Least-to-Most Prompting Enables Complex Reasoning in Large Language Models

- Denny Zhou (Google DeepMind): Teach language models to reason

此工作来自 CoT、Self-Consistency 的作者。

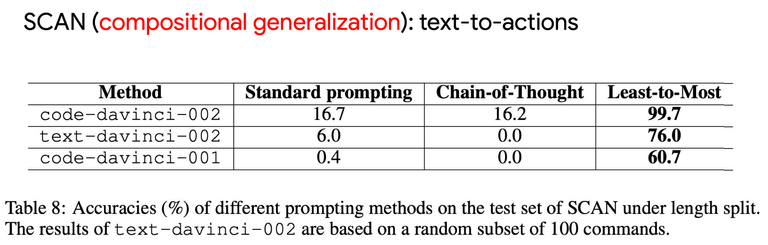

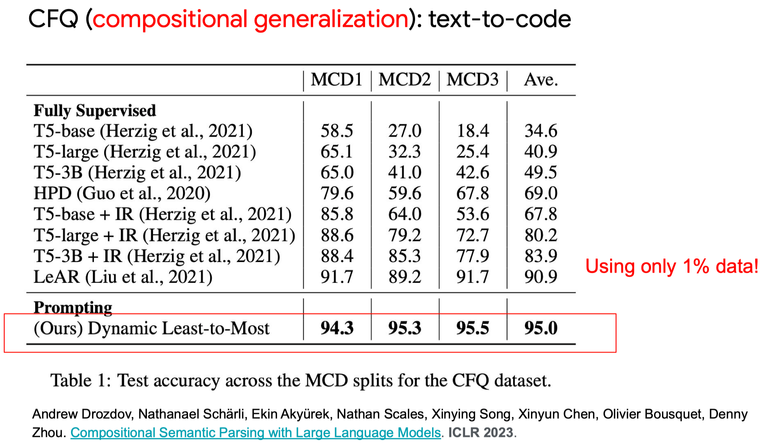

CoT 在容易的问题上效果很好,但在难的问题上效果不显著。而 Least-to-Most Prompting 主要是用来解决难的问题。

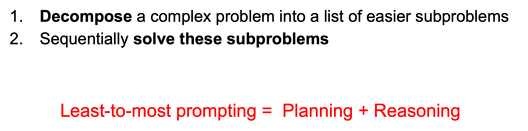

Least-to-Most Prompting

Least-to-Most Prompting 思路也很简单,就是先把问题分解成更简单的多个子问题,然后再逐个回答子问题,最终获得原始问题的答案:

除了上面的技巧,另一个技巧是在prompt中加入了少量样例(few-shot),这样可以显著提升效果。这个技巧在CoT中也有,是个提升效果很通用的方法。

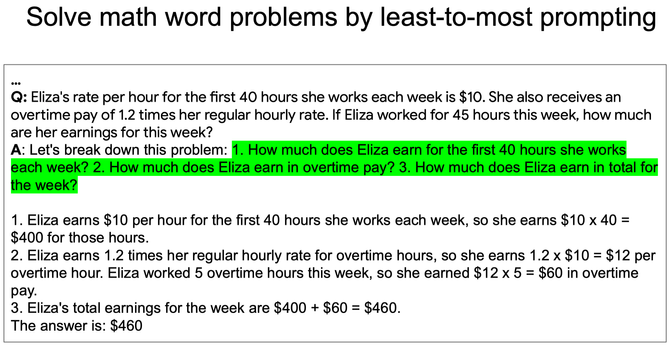

论文中在具体实现时,针对不同的任务,主要设计了以下两种prompt结构(省略了prompt中的少量样例):

- Let's break down this problem:

- 这种方式是调用一次LLM,让它先生成子问题,再生成每个子问题的答案,以及最终答案。所以主要靠样例来规范LLM的输出。

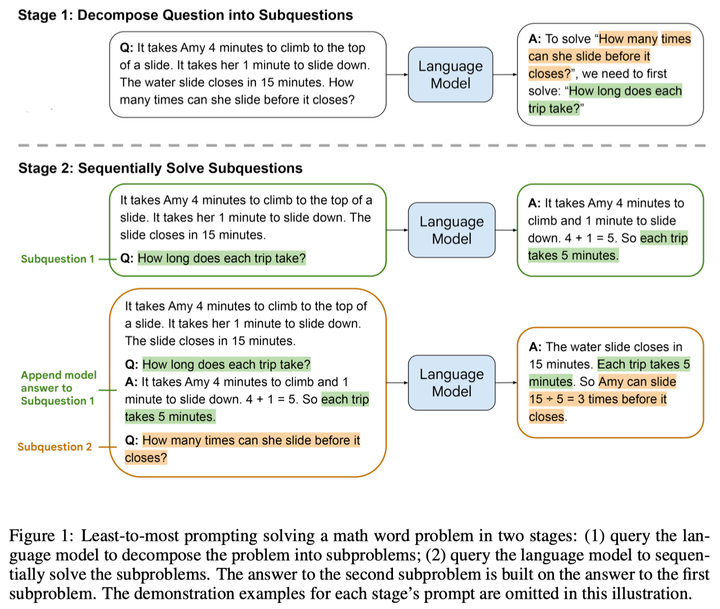

- To solve “

<problem>”, we need to first solve: “<subproblem1>”, “<subproblem2>”, “<subproblem3>”, … - 这种方式是迭代生成子问题的答案,汇总所有信息后再生成最终答案。

我理解prompt使用的具体提示词(

break down or first solve)不重要,重要的是先分解成子任务,再逐个解答的思路。效果

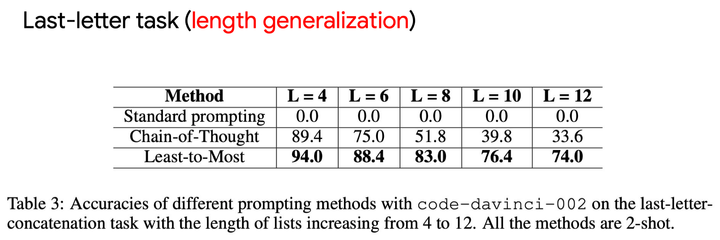

效果杠杆的。

<ins/>

- 作者:Breezedeus

- 链接:https://www.breezedeus.com/article/llm-prompt-l2m

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。

相关文章